FBIWARNING:本文一切知识点,知识框架均来自于个人对数据分析、数据挖掘、机器学习等方面的理解,推测均出自于本人的臆测,如果对数据分析感兴趣,可以参阅可汗学院的《统计学》、各大学的数据分析和机器学习课程。

数据分析定义

数据分析是指用适当的统计方法对收集来的大量第一手资料和第二手资料进行分析,以求最大化地开发数据资料的功能,发挥数据的作用。

“上帝函数”

吴恩达(机器学习领域四大牛之一)在coursera的《机器学习》中提到,对所有的数据总体而言,有且必然有一条能够完美解释此样本的函数,称为“上帝函数”。但是上帝函数无法通过计算得到(所有的统计,都是对样本的统计,而不是对数据总体的统计;另外对总体而言,即使数据是离散的,函数在复杂样本的数学意义上还是连续的),只能无限的逼近它。

数据分析方向

数据分析的数学基础在20世纪早期就已确立,直到计算机出现才使得数据分析成为可能,在计算机性能不高时,以计算机协助人进行统计学分析以获得数据判断,这种数据分析方法被称为数据分析或传统数据分析。

随着计算机性能增长以及最小二乘法和梯度下降优化思想得以被大规模应用到机器中,数据分析师得以从有价值的信息中更快速、更准确的得到更接近于“上帝函数”的数学结果。针对不同类型的数据集,也有不同的经典模型套用以快速求得最优结果。此时使用者已经不再关注基础统计学指标,而是转向了挖掘数据知识、关系探索等方向,这种数据分析方法被称为数据挖掘或机器学习。

传统数据分析本质

在各种场景下(限定条件/逻辑),应用统计学(工具)对数据分析后的结果进行解释(逻辑),得到更接近真实情况的客观数据帮助决策的一种判断方式。

数据集的描述和定义

传统数据分析工具

在大多数需要统计的商业环境中,大型工具基本只有两种:SPSS和SAS。SPSS属于傻瓜相机,利用定制好的选项和图形界面在略懂统计知识的情况下即可作出符合传统数据分析的结论;如果有更深层的需求,例如银行、金融等环境,SAS能通过SAS语言用编程的形式制作所需的数据模型,从而得到更高定制化、更精确、性能更高的结果;此外,还有统计师使用MATLAB编程来达到所需目标。当然,以上三款软件所需都是不菲。因此在python和机器学习走强的今天,传统的统计工具只能保全大型金融机构这样的大客户,还是走向了衰败。R、oracle等语言也跟着大放异彩。

描述性统计分析

描述性统计分析是传统数据分析的基础,在此过程中需要求出数据分析的基础指标,包括:

- 平均值:常用的统计指标,受极端值影响。

- 中位数:数据以升序或降序排列后,处于最中间的数。如果数据呈现二向分布,中位数的表达会受极大的影响,且不能表现数据中极端值的影响。

- 众数:出现最多的数,缺点同上。

- 方差/标准差:反应样本个体之间的离散程度,统计学重要指标之一,有较多的应用。

- 上/下四分位数:数据以升序或降序排列后,25%位置与75%位置的值,常用于箱线图等对数据的图像展示。延伸有四分位数间距

- 偏度:数据倾向于左边(左偏)或右边(右偏),对股票、公司财务健康等数据有较为重要的意义。

- 变异系数:数据标准差与平均数的比,反应离散程度,常用于对比不同量纲的数据中消除离散程度。

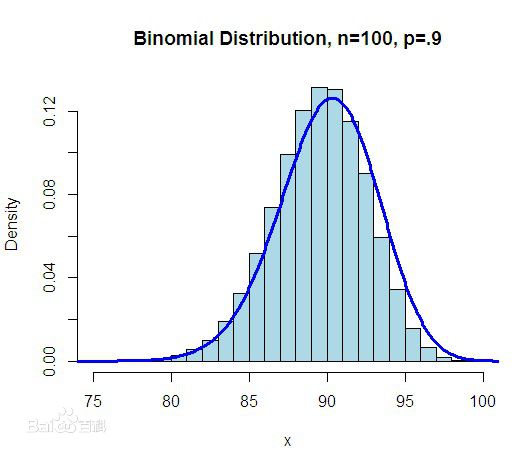

二项分布

二项分布即重复n次独立的伯努利试验。最简单的二项分布就是掷硬币游戏。虽然二项分布的概率是人类的常识,但二项分布的数学推导并不简单。此外,统计学中许多重要分布例如正态分布、伯努利分布、泊松分布等等都是以二项分布作为基础推导而出的。因此在统计学中,二项分布具有极其重要的意义。

正态分布

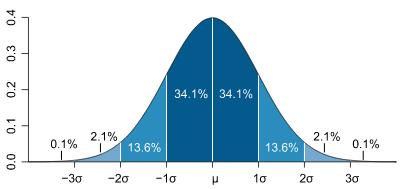

正态分布,又称钟形曲线。该分布展示了数据频数与分布域的关系,许多统计定理都是以正态分布为基础,该分布是统计学中的核心。详细描述请参考百度百科。

正态分布之所以有巨大的研究价值,是因为大多数干预或未经干预的数据都呈正态分布状,从自然界各个数值的分布,到人类的行为,产品的偏差,基本都符合正态分布模式(其实是因为中心极限定理,呈现为正态分布)。掌握正态分布理论意味着在不清楚总体分布情况时,可以根据该数据的属性做其是否是正态分布的推测,可以轻易获得某情况较为接近真实存在的概率。

正态分布也是统计学思维一种表现形式,“如果一直猴子坐在电脑前无限的敲打键盘,那么它终有一天能敲出莎士比亚全集”就是其中之一:从正态分布来看,我们无法绝对否定一件事情的发生概率,只能说“很有可能”会产生这样的结果,这也是有很多讽刺统计学家笑话的原因。 ## 泊松分布 泊松分布适合于描述单位时间内随机事件发生的次数。泊松分布在管理科学、运筹学以及自然科学的某些问题中都占有重要的地位。详情见百度百科。

泊松分布可以在掌握部分样本的情况下,推测其值落在各个区间的概率。 ## 经验法则和切比雪夫不等式 当一组数据对称分布时(经验法则):

- 约有68%的数据在平均数1个标准差以内。

- 约有95%的数据在平均数 2个标准差以内。切比雪夫不等式认为在75%个

- 约有99%的数据在平均数 3个标准差以内。

3个标准差以外的数据,在统计学上称为“离群点”。 当一组数据非对称分布时(切比雪夫不等式):

- 约有75%的数据落在平均数 2个标准差以内。

- 约有89%的数据落在平均数 3个标准差以内。

约有94%的数据落在平均数 4个标准差以内。

实际使用上,切比雪夫不等式的估算效果并不好,只有当经验法则无法使用时(无标准界定,常用于偏度>0.4)才会使用切比雪夫不等式。

大数定理和中心极限定理

大数定理和中心极限定理是统计学中最重要的两条定理,我认为因为这两条定理存在,才能切实的奠定统计学的价值,并且是统计学思维的根源 大数定理:又称大数法则,论证了在大量重复试验的过程中,样本量越多,样本平均值越接近于总体平均值。上文提到的切比雪夫不等式,是大数定理的一种特殊分布。详见维基百科。 中心极限定理:中心极限定理论证了在样本数较大时(通常定义为n>30),样本均值近似正态分布。该定理在大数定理的基础上,给出了收敛的极限分布和渐近方差,更深入的研究了正态分布,是数理统计学和误差分析理论的研究基础。详见维基百科。

概率

概率基础:从三个问题说开去

赌徒谬论

超生游击队员老王已经连生4个闺女了,但老王实在太想要一个男娃,虽然家产都快被村里计生委的人给罚光,但还是要生,他想,都连生4个了,下个肯定是个带把的。 那么问题是,下一个小孩是男孩的概率?

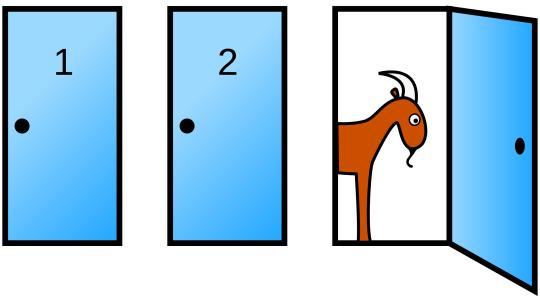

三门问题

假设你参加了一个电视节目,过关斩将来到了最后一关,此时你看见三扇关闭了的门,其中一扇的后面是一辆法拉利,另外两扇门后是山羊,当你选中了法拉利时,你就可以将其带走;如果选中了山羊,就会空手而归。支持人知道所有门后是什么。 你选定2号门后,主持人为了增加悬念,打开了3号门,门后是一只山羊,此时主持人询问你你是否要更换你的选择。那么问题是,是否应该更换选择?

### 辛普森悖论 你是一位校长,假设有一天漂亮的秘书跑过来对你说:“校长,不好了,有很多男生在校门口抗议,他们说今年研究所女生录取率是男生的两倍,指责我们学校有性别歧视!” 这时你也很生气,说:“我不是特别交代,今年要尽量提升男生录取率以免落人口实吗?” 秘书赶紧回答说:“确实有交代下去,招生办说今年的男生确实比女生多,可是报告上显示男生所有学科录取率都比女生低了很多。” 那么问题是:有可能在男生所有学科录取率均比女生低的情况下,总性别比例还保持不变吗?

### 辛普森悖论 你是一位校长,假设有一天漂亮的秘书跑过来对你说:“校长,不好了,有很多男生在校门口抗议,他们说今年研究所女生录取率是男生的两倍,指责我们学校有性别歧视!” 这时你也很生气,说:“我不是特别交代,今年要尽量提升男生录取率以免落人口实吗?” 秘书赶紧回答说:“确实有交代下去,招生办说今年的男生确实比女生多,可是报告上显示男生所有学科录取率都比女生低了很多。” 那么问题是:有可能在男生所有学科录取率均比女生低的情况下,总性别比例还保持不变吗?

辛普森悖论.jpg-8.6kB

概率论中需要注意的基础问题

以中国人平均数学水平来说,基础概率的计算基本不是问题,只需要注意一些概率计算的基本假设:

- 赌徒谬论:当事件与事件之间是相互独立的,不能联合计算概率,百度百科

- 三门问题:概率是随条件的改变而变化的,概率存在于被给予的条件下,概率不能寄托在实际的物体上,百度百科

- 辛普森悖论:在某个条件下的两组数据,分别讨论时都会满足某种性质,可是一旦合并考虑,却可能导致相反的结论,百度百科。

组合法则

组合法则是迅速计算在N内取n个有多少种方法的计算公式,体现为:

\[\left( \begin{matrix} N \\ n \\ \end{matrix} \right) = \frac{N!}{(N-n)!} \]

例如从4个项目中挑选2个来进行投资,则有:

\[\left( \begin{matrix} N \\ \end{matrix} \right) = \frac{4!}{2! 2!} = \frac{4\times3\times2\times1}{(2\times1)(2\times1)} = 6\]

贝叶斯定理

通常,事件A在事件B(发生)的条件下的概率,与事件B在事件A(发生)的条件下的概率是不一样的,然而,这两者是有确定的关系的;贝叶斯定理通过的是A、B事件转换而得到目标概率,贝叶斯公式的一个用途在于通过已知的三个概率函数推出第四个。

$ P(A|B) = $

下面通过一道题来理解贝叶斯定理。 对残疾人来说,电动轮椅很难驾驭。假设在房间的某一位置,轮椅使用者可以选择D(穿过房门),S(直行),T(停在桌旁),使用者意愿的概率分别是P(D)=0.5,P(S)=0.2,P(T)=0.3;当轮椅使用者将控制杆转向前时(记为J),则有P(J|D)=0.3,P(J|S)=0.4,P(J|T)=0.05。如果此时使用者将操作杆向前,各种情况的概率各是多少?

其中P(D|J)的解为:

P(D|J) = P(J|D) * P(D) / P(J)

P(D|J) = P(J|D) * P(D) / (P(D) * P(J|D) + P(S) * P(J|S) + P(T) * P(T|J))

P(D|J) = 0.3 * 0.5 / 0.245

P(D|J) = 0.612置信区间

置信区间:置信区间是对分布(尤其是正态分布)的一种深入研究。通过对样本的计算,得到对某个总体参数的区间估计,展现为总体参数的真实值有多少概率落在所计算的区间里(目前国内的统计不接受概率的说法,认为此操作不应属于概率的范畴)。置信水平越高,置信区间就会越宽;在置信水平不变的情况下,样本数量越多,置信区间越窄,且置信区间的需求样本量可以被计算出来。

一般来说,置信区间一般会选择95%。

假设检验

“反证法是统计学者最强大的武器!” – 想不起来谁说的了

假设检验是一种用反证法证明对立条件(原假设/H0),从而判断目前条件(备择假设/Ha)是否正确的证明方式。常见名词如下: P值:观测的显著性水平,通过不同方式计算后,如果P值落在原假设的拒绝域,则拒绝原假设。 接受域:原假设的区间。 拒绝域:拒绝原假设的区间。 I类错误:原假设为真时,拒绝原假设。 II类错误:备择假设为真时,接受原假设。

单样本下的计算方法

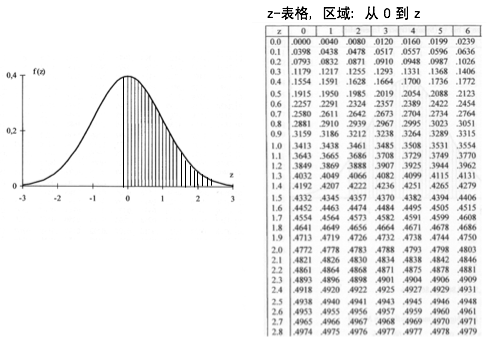

在单样本下,置信区间和假设检验主要使用z统计和学生t统计(也称t检验)。 z统计和学生t统计是两种应用正态分布,求置信区间的计算方式。z统计应用于大样本的计算,因为中心极限定理的存在,z统计不要求该样本分布属于正态分布(因为会整理成近似正态分布);学生t统计量主要应用于小样本的计算,要求总体分布必须近似正态分布,同时所取得的置信区间在同置信水平下也要比z统计得到的结果更宽。

两样本下的计算方法

两样本下,在统一量纲,消除样本均值差后,就可以使用常用统计方法来检验相关性。除了z统计和t统计外,还可使用卡方检验、F检验等。

在SPSS/SAS甚至excel等软件中,以上基础的检验方法都被大规模的修正/革新,所以基础的公式基本已经不会被使用了。 ## 更多样本,更多方法 在更多样本中,不同计算方法的差距会越来越大,传统数据分析更着眼于方差分析等检测样本相关性,简单线性回归线等,因此,样本的抽样和配对方法对模型造成的影响也会增加。除了以上介绍的统计方法,还有F统计,U检定等大项,每种大项下都有许多经过统计学家门修正的方法,在此不多赘述。

抽样组织形式

简单随机抽样:任何样本数为n的抽样几率都是相等的。 等距抽样/系统抽样:以总体N除以样本数n得到整数K,随机选择一个元素为R,以R开始,每隔K个的元素作为样本。 集群抽样:将总数分割成小的集群,再用简单随机抽样抽取小的集群,将集群作为样本。 二段随机抽样:先用集群抽样出集群,再对集群进行集群抽样。

传统统计分析总结

在以上知识的基础上,统计学家们更热衷修正原有的经典检验方法,以逻辑为推进从数学上增强各种推断检验标准,但也人类思维的局限性,模型的解释性强必然造成预测能力的削弱,这也是机器学习专家和统计学家重要的不同之处。统计学家集中了现代数学的精华,从数理上证明了SVM,boosting等理论基础,但是在实践和探索未知知识的路上,统计学家并未作出卓越的贡献。